共計 3388 個字符,預計需要花費 9 分鐘才能閱讀完成。

自動寫代碼機器人,免費開通

這篇文章主要介紹“ClickHouse 集群搭建的方法”,在日常操作中,相信很多人在 ClickHouse 集群搭建的方法問題上存在疑惑,丸趣 TV 小編查閱了各式資料,整理出簡單好用的操作方法,希望對大家解答”ClickHouse 集群搭建的方法”的疑惑有所幫助!接下來,請跟著丸趣 TV 小編一起來學習吧!

ClickHouse 是一個列導向數據庫,是原生的向量化執行引擎。它在大數據領域沒有走 Hadoop 生態,而是采用 Local attached storage 作為存儲,這樣整個 IO 可能就沒有 Hadoop 那一套的局限。它的系統在生產環境中可以應用到比較大的規模,因為它的線性擴展能力和可靠性保障能夠原生支持 shard+replication 這種解決方案。它還提供了一些 SQL 直接接口,有比較豐富的原生 client。

ClickHouse 數據庫的特點:

速度快 ClickHouse 性能超過了市面上大部分的列式存儲數據庫,相比傳統的數據 ClickHouse 要快 100-1000 倍,ClickHouse 還是有非常大的優勢。1 億數據集:ClickHouse 比 Vertica 約快 5 倍,比 Hive 快 279 倍,比 MySQL 快 801 倍。10 億數據集:ClickHouse 比 Vertica 約快 5 倍,MySQL 和 Hive 已經無法完成任務了。

功能多 1. 支持類 SQL 查詢;2. 支持繁多庫函數 (例如 IP 轉化,URL 分析等,預估計算 /HyperLoglog 等);3. 支持數組(Array) 和嵌套數據結構(Nested Data Structure);4. 支持數據庫異地復制部署。

要注意,由于 ClickHouse 的快速查詢還是基于系統資源的,因此在使用的時候要注意每個節點上的存儲量,以及節點機器的系統資源要充足。因為查詢時是使用內存進行聚合,所以同時并發查詢的數量不能太多,否則就會造成資源崩潰。

環境配置

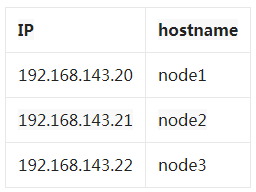

初始化環境(所有節點)

# 修改機器的 hostname vi /etc/hostname # 配置 hosts vi /etc/hosts 192.168.143.20 node1 192.168.143.21 node2 192.168.143.22 node3修改完后,執行 hostname node1…3,不用重啟機器使其生效

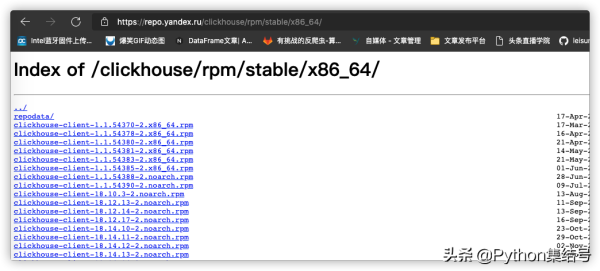

下載并安裝 ClickHouse(所有節點)

主要下載四個文件:

Clickhouse-client

Clickhouse-common-static

Clickhouse-server

clickhouse-server-common

rpm -ivh *.rpm安裝 zookeeper(任意一個節點)

# 我這里選擇 node1 docker run -d --net host --name zookeeper zookeeper配置集群(所有節點)

修改 /etc/clickhouse-server/config.xml

!-- 將下面行注釋去掉 -- listen_host :: /listen_host !-- 修改默認數據存儲目錄,比如在 /home 下創建目錄 clickhouse -- path /var/lib/clickhouse/ /path !-- 修改為如下 -- path /home/clickhouse/ /path修改 /etc/clickhouse-server/users.xml

!-- 配置查詢使用的內存,根據機器資源進行配置 -- max_memory_usage 5000000000000 /max_memory_usage !-- 在 /users 前面增加用戶配置 -- root !-- 通過 Linux 命令計算出密碼的 sha256 加密值 -- password_sha256_hex xxxx...xxxx /password_sha256_hex networks ip ::/0 /ip /networks profile default /profile quota default /quota /root增加配置文件 /etc/metrika.xml

yandex !-- ck 集群節點 -- clickhouse_remote_servers test_cluster shard internal_replication true /internal_replication replica host node1 /host port 9000 /port user root /user password 123456 /password /replica /shard shard internal_replication true /internal_replication replica host node2 /host port 9000 /port user root /user password 123456 /password /replica /shard shard internal_replication true /internal_replication replica host node3 /host port 9000 /port user root /user password 123456 /password /replica /shard /test_cluster !-- zookeeper 相關配置 -- zookeeper-servers node index= 1 host node1 /host port 2181 /port /node /zookeeper-servers networks ip ::/0 /ip /networks macros replica node1 /replica /macros !-- 壓縮相關配置 -- clickhouse_compression case min_part_size 10000000000 /min_part_size min_part_size_ratio 0.01 /min_part_size_ratio method lz4 /method /case /clickhouse_compression /clickhouse_remote_servers /yandex重啟 clickhouse 服務

service clickhouse-server restart # 如果不成功,則使用以下命令 nohup /usr/bin/clickhouse-server --config=/etc/clickhouse-server/config.xml $創建數據表(所有節點)

使用可視化工具連接每個節點,在上面創建 MergeTree

create database test; create table test.data ( country String, province String, value String ) engine=MergeTree() partition by (country, province) order by value;創建分布式表(node1 節點)

create table test.mo as test.data ENGINE = Distributed(test_cluster, test, data, rand());使用 Python 連接 clickhouse

安裝 clickhouse-driver

pip install clickhouse-driver執行命令

from clickhouse_driver import Client # 在哪個節點創建了分布式表,就連接哪個節點 client = Client(192.168.143.20 , user= root , password= 123456 , database= test) print(client.execute( select count(*) from mo ))到此,關于“ClickHouse 集群搭建的方法”的學習就結束了,希望能夠解決大家的疑惑。理論與實踐的搭配能更好的幫助大家學習,快去試試吧!若想繼續學習更多相關知識,請繼續關注丸趣 TV 網站,丸趣 TV 小編會繼續努力為大家帶來更多實用的文章!

向 AI 問一下細節